[휴스턴=뉴스핌] 고인원 특파원= 인공지능(AI)용 반도체 시장의 선두 주자인 엔비디아가 성능을 끌어올린 차세대 AI 반도체를 공개했다.

AI 반도체 시장에서 AMD와 인텔 등이 도전장을 내미는 가운데, 기존 GPU(그래픽처리장치)를 뛰어넘는 성능으로 이들과의 격차를 더욱 벌리겠다는 의도다.

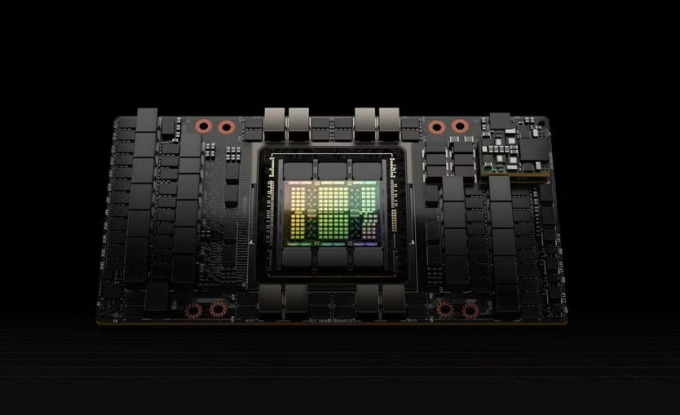

13일(현지시간) CNBC 등에 따르면 엔비디아는 이날 차세대 AI 반도체인 'H200'을 공개했다. H200은 대화형 인공지능(AI) 서비스인 '챗GPT' 개발사 오픈AI의 대규모 언어모델(LLMs) 챗 GPT-4를 훈련하는 데 사용된 H100의 업그레이드 버전이다.

CNBC에 따르면 업그레이드된 H200에는 141GB의 차세대 메모리 'HBM3'가 탑재돼 있어 AI 모델을 사용한 텍스트, 이미지 등의 생성 능력과 추론 능력이 한층 향상됐다.

엔비디아는 메타의 최신 대형언어모델(LLM) '라마2'를 대상으로 테스트해 본 결과 H200가 기존의 H100에 비해 처리 속도가 두 배가량 빠른 것으로 확인됐다고 밝혔다.

H200은 오는 2024년 2분기에 본격 출시될 예정으로 미국 반도체 기업 AMD가 지난 6월 출시한 최첨단 인공지능 GPU인 'MI300X'와 AI용 반도체 시장에서 경쟁할 것으로 보인다.

AMD의 MI300X 칩은 최대 192GB의 메모리를 탑재해 큰 AI 모델에 장착할 수 있다. 엔비디아 H100의 120GB 메모리를 능가하는 것이다.

엔비디아는 H200이 H100과 호환되므로 이미 이전 모델로 훈련 중인 AI 기업은 새 버전을 사용하기 위해 서버 시스템이나 소프트웨어를 변경할 필요가 없다고 밝혔다.

다만 H200가 엔비디아의 최신 AI 칩이라는 영광을 오래 유지하기는 어려울 것으로 CNBC는 내다봤다.

앞서 10월 엔비디아는 GPU에 대한 높은 수요에 부응하고 데이터센터 시장에서의 지배력을 굳히기 위해 새로운 GPU 아키텍처 개발 속도를 높이고 제품 출시 주기를 기존 2년에서 1년으로 단축할 계획이라고 밝혔다.

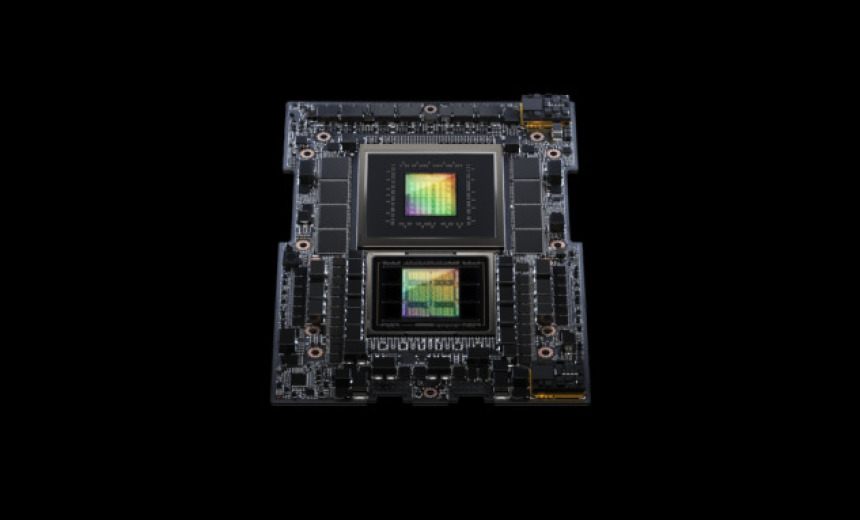

이에 따라 2024년에는 '호퍼(Hopper)'의 후속 아키텍처로 '블랙웰(Blackwell)'이 등장하고, 2025년에는 'X'로 지정한 새로운 아키텍처가 뒤를 이을 예정이다.

H100과 H200은 모두 엔비디아의 호퍼 아키텍처에 기반한 제품이다. 따라서 내년 호퍼의 후속으로 블렉웰이 등장하면 블렉웰 아키텍처를 기반으로 하는 신제품이 등장할 전망이다.

koinwon@newspim.com

영상

영상