기업들의 신기술 개발은 지속가능한 경영의 핵심입니다. 이 순간에도 수많은 기업들은 신기술 개발에 여념이 없습니다. 기술 진화는 결국 인간 삶을 바꿀 혁신적인 제품 탄생을 의미합니다. 기술을 알면 우리 일상의 미래를 점쳐볼 수 있습니다. 각종 미디어에 등장하지만 독자들에게 아직은 낯선 기술 용어들. 그래서 뉴스핌에서는 'Tech 스토리'라는 고정 꼭지를 만들었습니다. 산업부 기자들이 매주 일요일마다 기업들의 '힙(hip)' 한 기술 이야기를 술술~ 풀어 독자들에게 전달합니다.

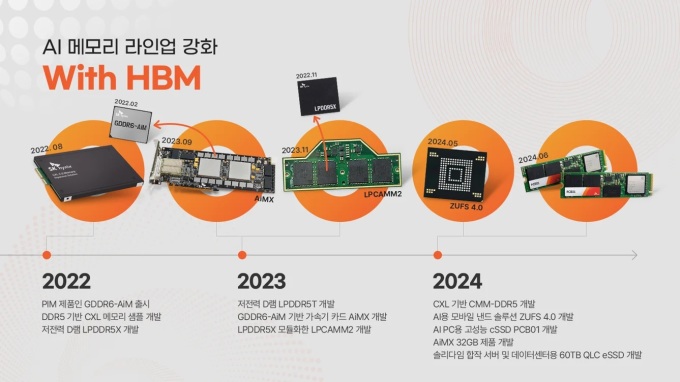

[서울=뉴스핌] 서영욱 기자 = 한 때 '메모리 반도체 만년 2위'라는 꼬리표가 붙었던 SK하이닉스. 하지만 인공지능(AI) 시대가 열리면서 AI 메모리 시장에서는 독보적인 1위로 올라섰죠. 2022년 생성형 AI의 등장 이후 다양한 제품과 서비스가 AI 중심으로 재편됐고, AI 기술은 빠르게 발전했습니다. 이에 따라 대용량 데이터를 처리하고 빠른 학습과 추론을 지원하는 고성능 메모리의 필요성도 크게 증가했죠.

SK하이닉스는 이 같은 시장 변화에 발맞춰 고성능 메모리 솔루션을 제공하며 AI 산업 발전에 핵심적인 역할을 수행했습니다. 그 주인공은 아무래도 고대역폭으로 대용량 데이터를 빠르게 전달하는 'HBM(High Bandwidth Memory)'인데요. 오늘은 HBM에 대해서 좀 더 자세히 알아보겠습니다.

◆HBM의 작동 원리는

중앙처리장치는 메모리에서 데이터를 가져와 연산을 합니다. 이 둘 사이의 입출력(I/O) 통로, 즉 대역폭이 좁으면 다음에 처리할 데이터가 즉각 도달하지 못해 xPU가 대기하는 병목현상이 생기죠. HBM은 이 통로수를 늘려서 대용량 데이터를 빠르게 전송하는 방식으로 작동합니다. 1차선 도로를 64차선으로 넓힌 것과 비슷합니다. 칩 하나를 기준으로 일반 D램의 I/O가 64개라면 HBM3E는 1024개의 I/O를 갖고 있습니다. HBM은 GPU와 함께 서버에 장착돼 AI훈련과 추론 성능을 높입니다. 서버 안에서 수많은 모델과 방대한 데이터셋을 처리하려면 고대역폭 전송과 고집적 특징을 갖춰야 하죠. 발열 문제로 낮은 전력 소모도 중요한 부분입니다.

◆SK하이닉스의 HBM이 특별한 이유는

적층한 D램 칩은 범프로 연결하고 칩 사이에 보호재를 넣어 포장해야 한다. 이 때 범프를 한 번에 녹이는 매스 리플로우(MR)와 보호재를 한 번에 굳히는 몰디드 언필드(MUF)를 활용한 기술을 MR-MUF라고 하는데, 열 방출과 접합 품질을 높이는데 아주 효과적인 방식입니다. 여기서 SK하이닉스는 이전보다 얇아진 칩이 적층 시 휘지 않도록 제어하는 신규 기술과 열 방출을 획기적으로 개선하는 새로운 에폭시 밀봉재를 적용해 기존 MR-MUF 장점을 살리면서 생산성은 약 3배, 열 방출 성능은 약 2.5배 끌어올린 Advanced MR-MUF 기술을 HBM 공정에 적용했습니다.

D램 칩에 수천 개의 구멍을 뚫고 수직관통전극으로 연결해 대역폭을 넓히는 기술을 TSV라고 합니다. 특히 적층된 D램 칩은 전류가 통과하면서 저항에 부딪히고 이로 인해 전압이 감소하는 현상이 발생하는데요. SK하이닉스는 이러한 전압 강하로 메모리 성능과 안정성이 저하되지 않도록 PDN(Power-Distribution Network) 특성을 개선한 TSV 기술을 적용하고 있어요.

HBM3E에서는 코어 다이의 엣지부터 중심, 중간 제어 영역 등 가능한 모든 위치에 TSV를 배치해 전력 TSV 수를 HBM3 대비 475% 늘리고, 동적 전압 강화를 최대 75% 개선했습니다.

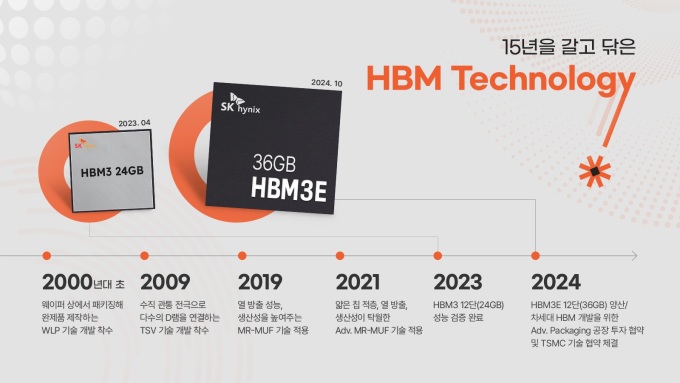

SK하이닉스는 2013년 세계 최초로 HBM을 선보인 뒤 최초이자 최고 성능의 제품을 꾸준히 선보이고 있습니다. 지난해 5세대 제품 AI용 초고성능의 HBM3E를 개발했고 올해 세계 최초 양산과 고객 납품을 시작했습니다. 특히 HBM3E는 전작인 HBM3 대비 속도는 1.3배 빨라졌고 용량은 1.5배 늘어났습니다. 동일한 속도에서 전력 특성을 10% 개선하기도 했죠.

HBM3E의 초당 처리 속도는 최고 9.2GB 이상 데이터 처리량은 초당 최대 1.18TB로 쉽게 말해 약 5GB의 Full-HD급 영화 230편 이상의 데이터를 단 1초 만에 처리할 수 있는 수준입니다.

◆6세대 HBM까지 개발 속도

올해도 SK하이닉스는 AI 리더십을 공고히 하기 위한 전략적 행보를 이어가고 있습니다. 지난 4월 미국 인디애나주에서 어드밴스드 패키징 생산기지 건설을 위한 투자 협약을 체결했습니다. 차세대 HBM을 비롯한 AI 메모리가 이곳에서 집중 생산될 계획이죠. 같은 달 TSMC와의 기술 협약 또한 체결했습니다. 회사는 고객·파운드리·메모리 간 3자 협업 체계를 구축, 메모리 성능의 한계를 넘어서고 AI 시장에서 우위를 가져간다는 계획입니다.

41주년을 맞은 SK하이닉스는 기술적 한계를 끊임없이 극복해 나가고 있습니다. 다변화한 AI 서비스에 발맞춰 각 고객에 최적화된 맞춤형(Custom) AI 메모리를 개발하는 데 집중하고 있고, 혁신 소자 기반의 차세대 이머징 메모리도 개발 중입니다. 기술 개발에 끊임없이 투자 중인 SK하이닉스는 HBM3·HBM3E를 비롯해 6세대 제품인 HBM4까지 성공적으로 개발해 기술 리더십을 유지할 수 있을지 지켜보겠습니다.

syu@newspim.com

영상

영상